全文14323字,大约需要30分钟左右。

如题,应邀写一篇关于B2B官网SEO优化文章,内容核心是围绕B2B官网常见优化内容进行总结,分上篇、中篇、下篇。这是上篇,主要围绕SEO基础能力做介绍。您若不弃,也可照猫画虎,逐一核对自家站点进行自查。

本文不一定能帮助你成为SEO大佬,但不管你是SEO老炮还是SEO新手,它在一定程度上能助你更深入了解SEO具体要做些什么,也能让其他人更清楚了解你的角色定位。

当然,也不指望你能一次性消化所有内容,毕竟有些实施项目是要调用你所储备的技术能力模块,比如:爬虫原理、前端(Div+css)、Js/Php、Python、Linux及服务器运维能力要求等。于我而言,这才是一名合格的SEO工程师该有的样子,当然,我不是唯技术论,但为什么要这么强调,因为日常工作中这直接关乎到与你相关的上下游,举个例子,突然有一天发现网站打不开,排除一些客观原因(如断网等),更多的还是需要你通过多方排查找出问题所在,“是不是服务器宕机、域名解析失效、网站是不是被打了”等等,这些细节都需要建立在有一定的技术知识储备,不能什么事情都直接扔给开发或者运维,试想你公司没有这样的人员怎么办呢,所以面对技术问题是你的常规课题,你若不具备处理能力,那至少需要具备描述问题的能力,否则你会显得很无助,用现在的话说,你会很拉垮。

诚然,文中某些细分知识点也不可能通过一篇文章就能讲透,再加上我的解读水平也有限(毕竟不是科班人士),因此只做了一个简单普适版的,具体会按照目录顺序一一详解,文中若有讲述不正确的,欢迎大家批评指正!最后,衷心希望能为大家提供不同的视角来理解这个行业和工种,有必要或者感兴趣的,可以加下方微信私聊!

飞优网主理人 Rapheal Lau

9年数字营销Adtech背景,专注B2B领域网站建设、SEO/SEM(搜索引擎营销)、数字营销体系建设与落地执行。最佳实践:官网1个月上权2,实现ROI达1000%的效果,纯白帽手法。

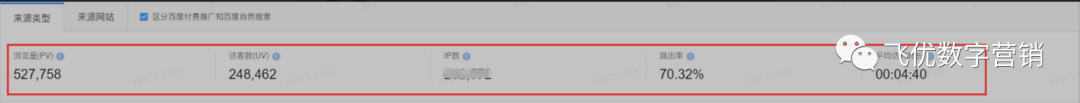

先看看以前负责的案子,这是一个底子比较好的企业站,接手时PV20万不到,经过10个月的时间,全年实现527758pv,翻一番。(流量虽然不是特别大,但是整体的线索精准度不错)

因此,我将历年来负责的优化项目进行总结,整理出一份2022年官网SEO优化必备清单,希望对大家有帮助。

文章目录上篇:SEO基础+技术SEO中篇:关键词研究+页面SEO+内容建设下篇:链接建设

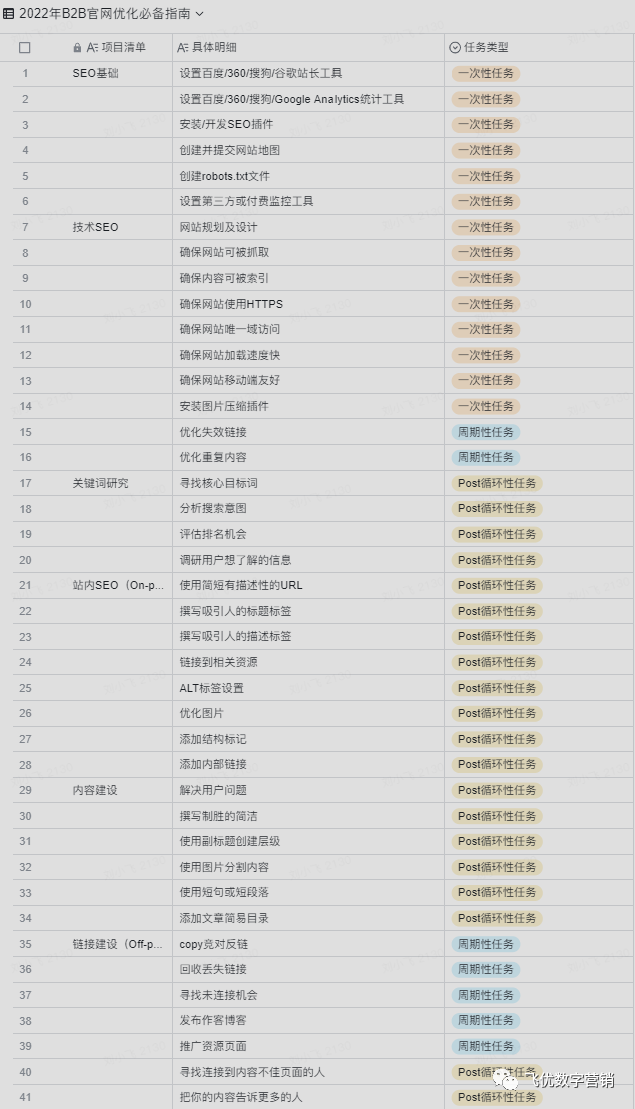

附:2022年B2B官网优化落地执行清单↓↓↓

看到如此之冗长清单,心中不禁一颤,究竟该如何利用SEO优化指南指导日常的官网运营工作?来,走着!

SEO基础

设置站长工具

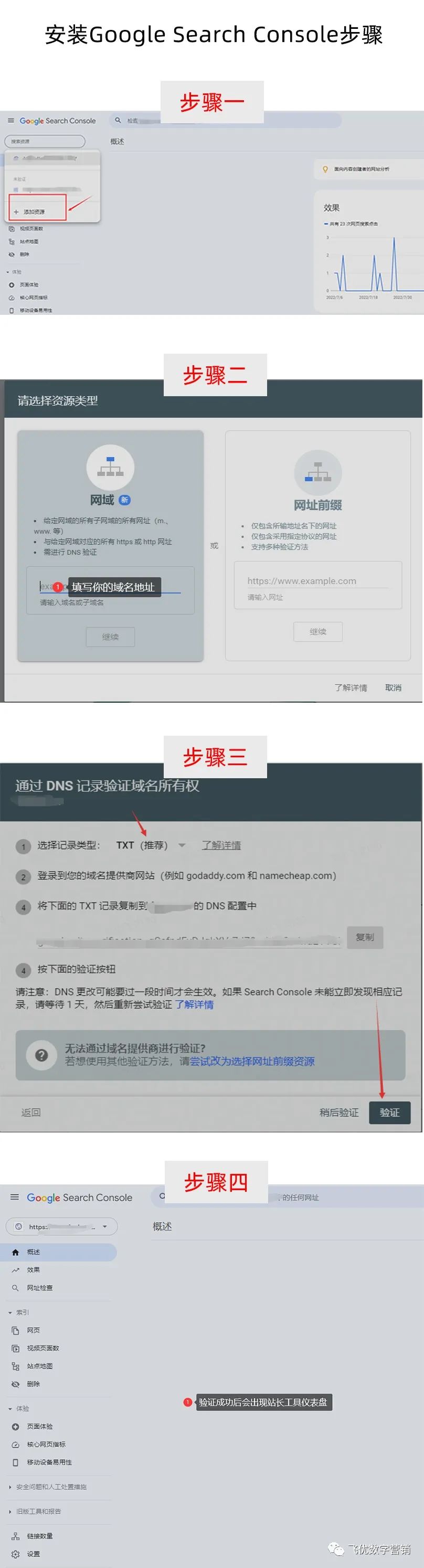

将百度/谷歌较为常用的站长工具配置在你的网站中,国内SEO优化一般是以百度为主,海外或者Google SEO可以考虑Google Webmaster Tool,也就是Google Search Console。关于安装代码可以直接百度,以Google Search Console安装举例,具体有两种方法可以安装:

Google站长工具安装为例

方法一:通过域名解析实现

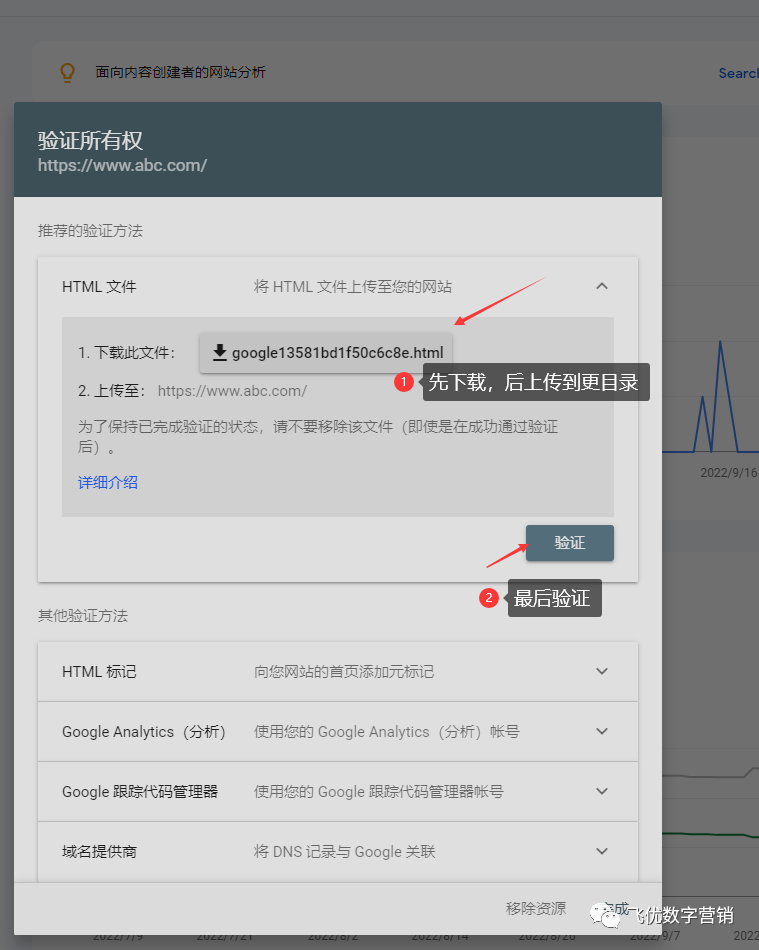

方法二:提交网站前缀资源文件上传根目录

另一种方式验证只需要将网址协议与域名填好,在后台下载一个带有追踪参数的链接上传到网站根目录,这个最为便捷(推荐此法)。

Tips:安装Google Search Console 需要搭梯子,否则不会验证成功。

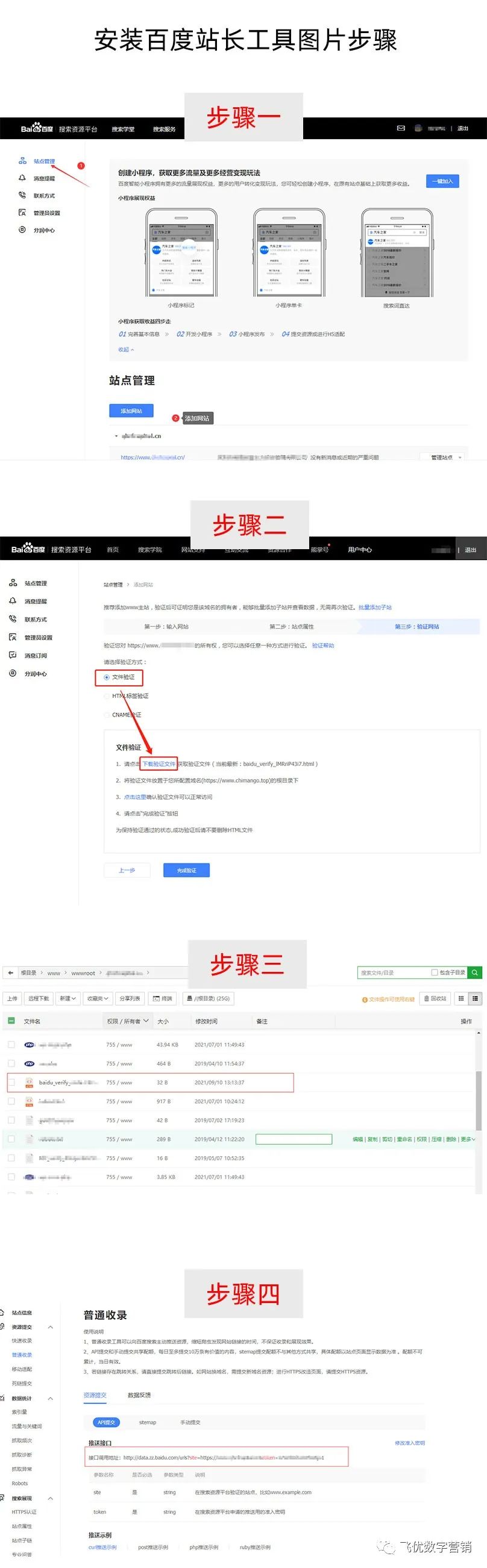

百度站长工具安装图片步骤

点击查看更多百度站长工具安装详细教程。

其他的站长工具安装方法同理,百度和谷歌两个工具是可以相互补充使用的,这为后面进行站内优化索引量覆盖检测是有明显优势的。

以上两种站长工具安装完后需要再进一步进行百度统计+Google Analystics工具安装,步骤类似,也是需要将异步代码安装到网站首页标签之前,详细教程可以度娘一下。

集成SEO功能

假如你的网站是通过开源程序制作的,比如:wp、dede、z-blog、dzx等,那可以通过第三方插件库进行插件下载安装,以WP为例,比较好用的是Yoast SEO插件,该插件功能比较强大,常见的能修改TDK及创建相关推荐等内链结构设置。

Yoast SEO仪表盘

当然,以上是基于第三方开源程序安装的,有些企业是定制网站(区别于开源程序,委托第三方或自己的技术部门开发搭建),这种情形就需要SEO工程师与开发进行项目需求沟通,经评估后最后集成在站点里,方便SEOer在后台进行直接自定义编写,切记要开发写一个了可视化的配置页面,不要开发者直接在源码进行改写,这样是不明智的做法。

创建Robots.txt文件

3.1 何谓Robtots协议?

Robots协议是爬虫与网站之间的一种明文规则,它能告诉爬虫哪些是能够抓取访问,哪些是禁止抓取访问的,当然这是一种理想状态,但是也有极个别的爬虫不一定会遵守协议规则。

在日常SEO优化工作中如何查询一个站点有没有设置Robots.txt协议?

很简单,你只需要在目标网站上输入

https://你的域名/robots.txt

即可,你会看到如下内容:

Robots文件在很大程度上都不会被待见,尤其是在开发者眼里,他们觉得没什么作用,相反还会带来负面,为什么?因为容易被黑客盯上,通过禁止访问的文件夹和信息,黑客会找出程序bug攻击(尤其是开源程序,因为代码是公开的,很容易找出漏洞),这样会导致你的站点损失惨重,以上图为例,不难发现该网站是用wordpress搭建,通过Disallow信息可以看出禁止爬虫访问后台,插件目录,动态链接、astra钩子(这可能是主题下的目录)、重定向链接地址目录,假如别有用心的人看上了会根据这些提示信息一步步测试找出漏洞,最后实现攻击目的。

3.2 Robots协议有哪些好处?

首先可以告诉搜索引擎爬虫哪些页面可以抓取,哪些不可以抓取,有助于优化。

比如:一个商城网站通常会有购物车页面,实际上在SEO上毫无用途,所以可以直接告诉爬虫进行禁止访问,因此可以直接写入规则:

User-agent: *//冒号前有一个空格Disallow: /cart/ //冒号前有一个空格

3.3 Robots协议如何创建?

创建robots协议之前需要认真掌握下Robots协议语法构成及书写规则,就上述规则做个解释说明:

User-agent //代表搜索引擎类型;* //代表所有搜索引擎类别;Disallow //禁止访问指令;Allow //允许访问指令;/ //代表根目录。

举一反三,我们不妨思考下:假如我要屏蔽百度蜘蛛访问网站根目录,具体该怎么写入规则,按照上面的介绍不难写出:

User-agent: Baiduspider

Disallow: /

3.4 Robots协议的使用场景

有一种常见情形:当网站处于线上/测试阶段时,我们也可以利用robots 协议进行屏蔽告诉爬虫禁止访问网站,这样便于为做好内容准备。肯定有些“刁民”会说,不在本地测试直接在线上测试这样不会导致网站进入沙盒期吗?这种情况会有,但是我实际操作每次都是在线上,至今没遇到过,大家可以实际验证下!

点击查看关于更多百度爬虫类型拓展阅读

创建sitemap文件

4.1 Sitemap释义

Sitemap即网站地图,打个不恰当的比方,sitemap好比一条河流系统,水如同搜索引擎爬虫,河流中不乏一些支流,这些支流形成一个巨大的网络结构,支流结构就好比网页结构,各条支流就好比是网页上的具体目录和页面信息,爬虫的访问就好比水流流向各支流的行为,因此它能够有效地告诉搜索引擎关于你的站点中的网页、视频或者其他文件的相关信息,帮助搜索引擎更好的认识和理解你的站点。

实践中的sitemap内容与格式

4.2 Sitemap的编写格式与要求

上图是一张关于插件制作而成的sitemap文件,sitemap文件一般以sitemap.txt和sitemap.xml两格式为主,一般后者应用较多,常见的sitemap格规范,分别举例谷歌和百度sitemap实例说明:

谷歌 SitemapThe

http://www.example.com/

2005-01-01

monthly

0.8

百度 Sitemap

http://www.example.com/

2021-01-01

daily

1.0

基本上文件标签一致,具体XML标签释义:

changefreq:页面内容更新频率;lastmod:页面最后修改时间;loc:页面永久链接地址;priority:相对于其他页面的优先权;url:相对于前4个标签的父标签;urlset:相对于前5个标签的父标签。

另外一种TXT即纯文本格式,这种格式的站点地图优势在于:

生成简单,生成TXT格式的Sitemap(站点地图)仅需注意下列事项· TXT格式的Sitemap每行都必须有一个网址。网址中不能有换行。

· TXT格式的Sitemap不应包含网址列表以外的任何信息;

· TXT格式的Sitemap必须书写完整的网址,包括http或者https;

· 每个TXT格式的Sitemap最多可包含 50,000 个网址,并且应小于10MB(10,485,760字节)。如果网站所包含的网址超过 50,000 个,则可将列表分割成多个文本文件,然后分别添加每个文件;

· TXT格式的Sitemap需使用UTF-8编码。

通用性强,几乎所有的搜索引擎,均支持TXT格式的Sitemap文件;

不过TXT格式的Sitemap(站点地图)也有其自身的弊端,它仅仅能够做到将url告知搜索引擎,而无法在Sitemap(站点地图)中传递更多的信息。

4.3 其它格式的Sitemap(站点地图)

如果你的网站是WP搭建的,可以直接在后台插件-下载谷歌sitemap插件,这个是支持的。(如上图插件截图所示)。

在生成Sitemap(站点地图)后,我们还应该确保Sitemap(站点地图)和robots.txt 规则不要发生冲突。Robots协议文件中可以添加sitemap的静态URL地址。

4.4 Sitemap和Robots.txt的协同

如果在Robots.txt文件中,为一个页面使用了“noindex” 标签,那么它就不应该出现在站点地图中。

否则,搜索引擎的爬虫会认为“这个页面很重要,所以它被添加到站点地图中”。但是当爬虫去访问这个页面时,又被Robots.txt阻止访问。

所以在Sitemap(站点地图)提交的时候,一定要注意提交的内容,是否和Robots.txt有所冲突。

安装其他第三方工具

安装第三方工具主要是以付费统计工具居多,从公司经营角度上看主要考核人效。为什么这么说?一般而言,在ToB领域,官网是衔接各个流量节点的重要枢纽,不同的企业有不同的组织结构,负责该工作的配置也不可能是千篇一律,所以考虑到市场部各端口的Roi时,我们需要进一步解决渠道溯源问题,那实际上就需要掌握流量从前端-中台-后台,从流量到成交环节,这些实际的数据是怎样的。在日常运营工作中,我们就需要优先去解决与相关部门或兄弟小组能够达成一致的规范及标准。当然,我们是通过设置标签的方式解决这个问题的,处理好这些问题后非常方便后期通过调用标签来路找出属于哪个渠道,当然标签的设定需要结合实际业务,这样有助于进行渠道精准分析,便于进行ROI核算,否则当数据量庞大起来你会一团乱麻。

假如你现在有精细化运营打算,那从此刻起就开始先从市场部出发,以各端口为单位做建制建立一套完整的核算标准体系。

技术性SEO

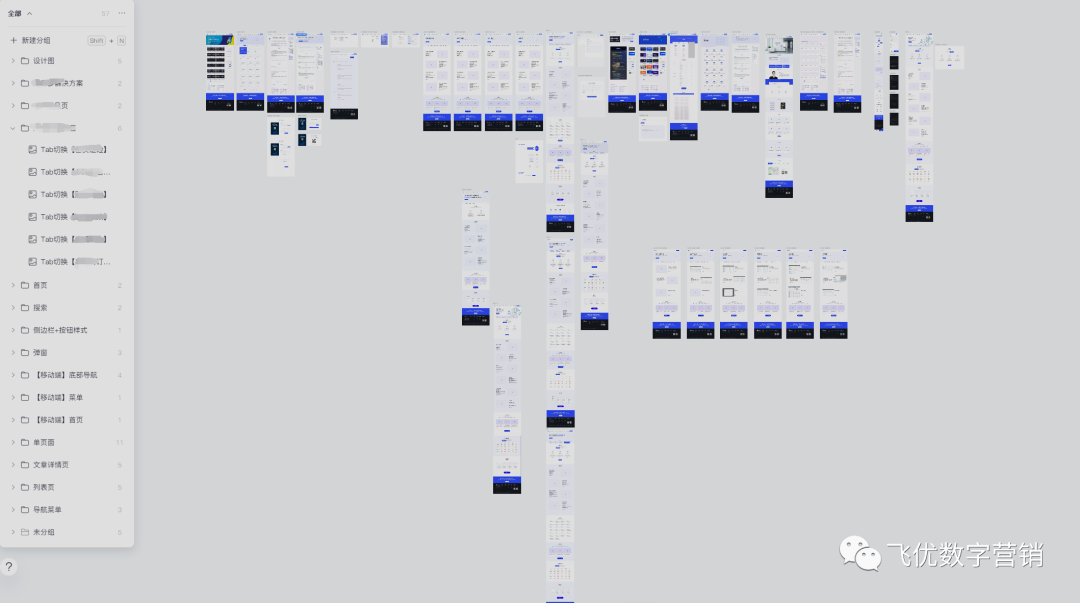

网站架构设计与规划

网站的结构与网站的转化有一定的直接联系,一个高转化的网站必定会有清晰的网站结构脉络,最直观的感受就是前端展现的每一个结构都具有层次感及结构化,泾渭分明简单明了。这些都取决于你前期方案与规划包括哪些方面,技术开发方案选型是一个不可忽视的环节,优秀的技术开发服务商是会考虑SEO的,其他的可能就不会那么注重了,因此有些SEOer拿到这样的网站分析后觉得很难优化上来所以就会开始考虑改版,当然也有些主要是觉得它长得不好看。By the way,不要轻易改版,流量真的很容易受伤,所以能在前期策划阶段解决的就尽量在前期做好做全,在选型阶段就要全程参与进来。我具体以改版网站举例来说明。

改版前我们需要先明确目标,也就是为什么要做重建网站或改版?正所谓“谋定而后动”,这样会事半功倍,假如前期没有想好那我奉劝你最好打消这个念头,因为最终会面临“竹篮打水一场空”的结局。

言归正传,那具体该怎么落地网站架构设计和规划?不妨参考下我的做法:

1.1 确定项目的基本目标

一般而言,在SEO领域不建议轻易改版,因为大概率都会造成权重下跌,严重的时候可能一下子会回到解放前,这对SEOer来说是致命的,因为需要毕其功于一役做提权的策略,这是一段苦行僧的过程。言外之意我们需要重视网站改版的目的,按常理,网站改版最常见的2个因素:提升流量获取增长和品牌升级。

先说品牌升级

品牌升级的改版通常伴随着是对网页设计及视觉要求比较高,更多是强调行业的权威性及设计感官体验上的个性化,苹果官网是最好的诠释,针对这类型的官网改版实则对SEO没有多大用途,因为弱化了SEO功能,因此这里就不做详细介绍。

提升流量获取增长

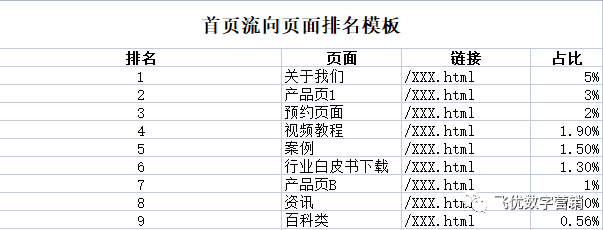

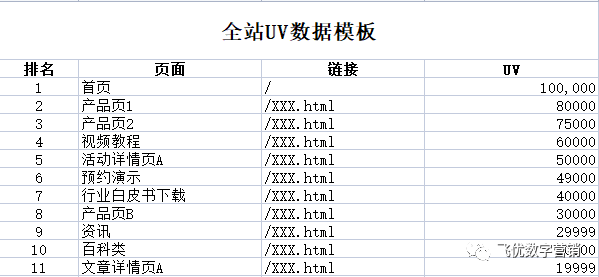

平心而论,当一个站点遇到了流量瓶颈期,导致增长变缓,业绩面临双重压力时,我们可以考虑改版了,改版需要遵从数据先行原则,通过数据端找出问题所在,全面筛查网站的哪个环节导致,从数据中找到不确定性,从不确定性中找到方法。这里就可以利用前面所提及的通过统计工具监控站点找到一些蛛丝马迹,发现问题的症结所在以便更好的指导改版规划,比如:通过分析整站中首页流向其他页面或导流的数据比重和整站访问最高的页面UV/PV、上下游页面之间的关系等等,通过细微的数据变化溯源找出哪些页面及栏目如何调整,为便于后面给出方案我建议大家可以按照以下模板拉取具体数据表来进行分析及总结:伸手党可以点击原文回复关键词下载模板 流量数据分析模板

通过这些细节步骤,再结合整体的日均流量数据、线索反馈数据再看前端的网站表现层,具体查看注册/登录/预约等留资页面体验设计,这直接关系到页面的留资的多少,之前本人就忽略过这个方面,导致错失一波流量,不及时处理这些都是致命的隐患。由于这个部分的内容过于精细化,也属于数据分析的内容,这里就不做详细阐述,后面我会在下篇中详细介绍。

以上种种完成后梳理一个具体的改版应对优化建议,比如:

解决产品聚焦度单一问题

建议:设置层级分类架构,层级分类架构更简单明了,缩短访客访问路径,让优者更优。

解决部分页面浏览量偏低问题

建议:可采取优化形式通过优化展现形式,可以布局在首页入口更直观。

站内检索弱

建议:新建检索功能,加强信息检索能力,合理分类搜索结果及优先级排序。

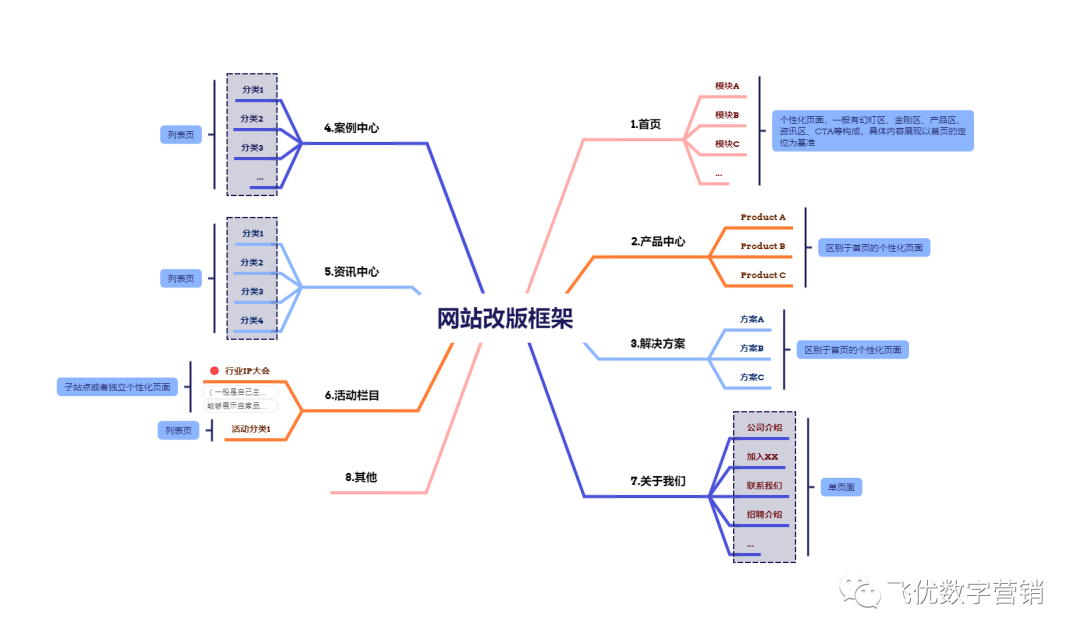

当这些前置动作处理好后即可根据思路画出改版的结构大纲及后续原型。

1.2 画大纲及原型

附上我的草图大纲,这里强烈建议利用思维导图进行网站结构梳理。

网站的栏目架构是可以随时调整的,但是需从网站定位出发,因此栏目归类非常需要满足逻辑和相关性。以资讯中心为例,这属于一级目录(父类栏目),可以设置很多子类,因此有些ToB的企业喜欢把这个栏目定义为Blog,然后将很多子类归在父类之下,子类包含一些常见的行业资讯、文章干货、白皮书、活动频道板块等,无所谓对错,但是根据我的经验判断,这是采用了海外站点的栏目归类法。其他的同理。

栏目的归类解决后,最为重要的莫过于首页的布局与设计,首页好比网站的门面,对用户的留存影响巨大,因此ToB的官网也肩负着既「有用」又「好看」的重任,二者需要做到统一。

「有用」决定了网站的里子,能从根本上解决用户的诉求,不管是解决信息获取还是下载需求,能够满足这些基本的要求这算得上合格。决定是否「有用」取决于你的页面需要表达什么,具体是以解决什么样的需求逻辑为前提,一般我会根据3WTD原则布局内容。通俗点说,就是要让页面按照这个底层逻辑自己“会说话”,以一个常规性首页布局为参考说明,如图:

“会说话”的页面原型示例

这个首页我们分了9个区块,对应的注解如下图所示,为什么会这么布局,这是有一定的逻辑性的,也就是我要讲的3WTD布局内容模型。

首页布局的底层逻辑原理注解

What ——“我们是干什么的”

关于What部分,通常在页面的幻灯区去布局,优先展示产品价值主张及公司定位,一般会用一句slogan作结,再配合相应的出彩设计,有些公司直接用产品的价值主张进行文案撰写与物料设计,这个取决于你的推广目标,你究竟想让用户了解些什么。

Who —— “我们要解决谁的问题”

解决谁的问题,主要与官网前期网站用户定位有很大关系,从我们多年的经验来看,访问我们站点的无外乎以下三类人群:泛读型用户(跳读为主)、专业沉浸式重度用户(参与性,有较好的品牌认同感)、非专业型用户(投资者、应聘者为主)。因此在定位前期需要解决这三大类参与角色的需求,你需要设计不同的内容尽量满足这些群体,若是要按比例来,不妨按照3:6:1的比例进行内容规划及设计,主要还是围绕精准用户进行内容设计,这也是决定你未来站点是否有精准转化的核心所在。另外,单在首页布局中如何安排内容设计?同理,还是要围绕解决用户的核心需求为基准,将需求透析,通过行业报告、调研、内部访谈等手段找到需求的使用场景,将用户进行分层,针对不同的用户不同的使用场景进行文案描述,最后以场景化设计表现出来,其目的主要为引发用户深层的共鸣,刺激用户的需求欲望。

Why —— “我们为什么要这么干”

关于why的解决思路,主要围绕自家产品与服务核心价值来布局,从业务痛点与解决方案的角度入手尽可能从用户的视角撰写文案进行白话输出,这样便于将用户的需求进行关联,便于转化,在文案撰写和策划中切忌堆专业词汇(因为你嗨了,用户却懵了),非用不可建议做下注解。

Trust ——“凭什么相信我们”

此区块的设计原则是解决用户的不信任感,B端产品与C端产品很大的不同点在于: C端更注重体验,而B端着重为客户解决问题及创造价值,同时也更强调抽象与逻辑,一定程度上用户的购买决策链条较长,所以用户不会因为兴趣使然而产生购买行为,因此我们需要需要找准切入点,不妨利用自己的产品服务的最佳实践进行教育,消除用户的疑虑,让其产生对品牌的好感,激发用户对品牌从众心理。除了相应的头部案例剖析之外,还需要有一定程度上的技术奖项(有含金量的奖项)这些都在一定程度上能实现与用户沟通的最小解释成本。

Do ——“行动起来”

这是页面布局的最后一个环节,前面3个部分做好后,有需求的用户自然而然就会主动与我们产生联系,因此我们需要提供为用户留资的入口,设计好转化路径,引导用户最终流量那一个页面进行闭环。往往这也是衡量一个ToB网站做得好与不好的一个标准体现。当然CTA的布局也不是随意的,也有一定的规律(提高点击),除了样式上的丰富形态之外,更取决于你的文案煽动性,好与不好都需要进行检验,常见的检验方式就是A/B测试。

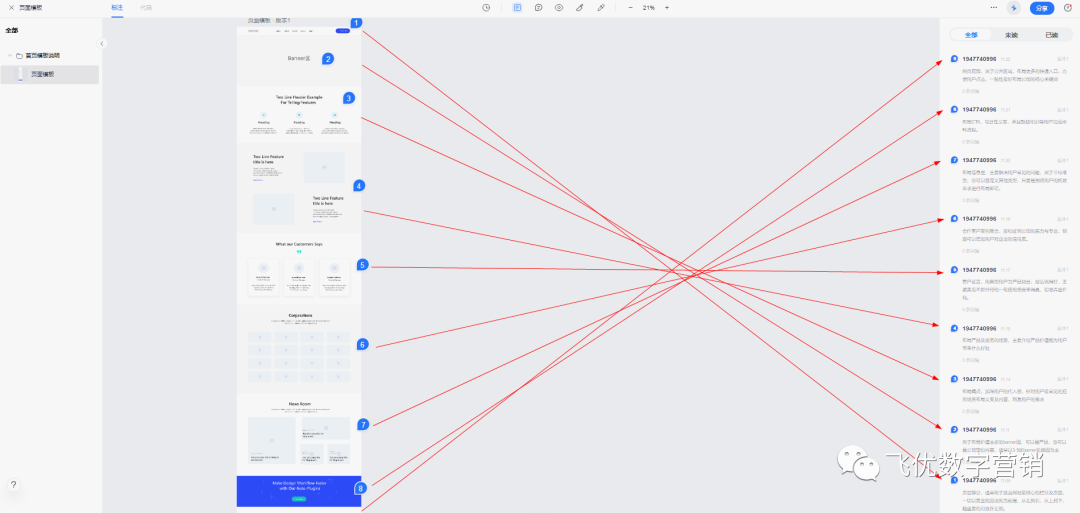

前面也提到过,符合ToB官网的既要满足「有用」,同时也要兼顾「好看」。「好看」是建立在「有用」的基础上的扩展,属于感受层,这并不是说设计一定要浮夸和刻意追求好看,但他一定是符合行业审美标准的,坦白讲,取决于PM,没有PM的,取决于你操刀的设计师是否具备严格意义的审美观。比如:2022年Tob领域的行业设计风格是怎样的,是3D风格、2.5D设计、还是轻拟物风格等,这些都需要设计师多观察和多看业内经典case,若实在不清楚可以了解大厂的设计风格,其实最好的老师就是BAT,可以看看他们的官网产品设计风格,一家不足以代表趋势,可以多看一些,若各厂商的设计风格如出一辙,这就能说明行业的整体设计风向基本定型,是可以参考的,这里扯得有点远了,回到正题,当你的栏目的决策树模型按上述的流程完成后,接下来就有必要开始画原型设计了,原型设计可以根据自己对工具掌握的熟练程度进行完成,精通的推荐:Axure RP9、Adobe XD、墨刀,要(想)求(做)高(卷)点(王)的可适当画出高保真的原型设计,不熟悉原型工具的直接用excel或Word画一个线框图就好,具体能够表达出页面的框架和布局就行。当然有能力的把原型做完后可以顺便出一个原型交互释义说明。自然我认为这是多此一举,因为80%前端开发人员是能够看得懂页面的交互,除非不专业。我当初的改版原型设计做了大概15个版本,具体到35个页面设计,现在回想起来原型输出方案详细与否取决于你Boss的理解水平。

上图为近期改版设计的高保真原型

1.3 设计环节

原型设计好后可以安排UI/网页设计师进行静态页面设计,该工作是一个细致活儿,说具体点,你前期可能需要更多次的同频,需要与UI设计及前端开发人员讲述页面布局与设计的逻辑原理,尽可能多还原项目的背景,不然从他们的角度出发,后期输出的东西可能和你表达的完全不一样,因此需要不断地沟通达成共识,消化掉每个疑虑。期间肯定是少不了磕碰的,比如设计追求的美感需求牺牲部分的体验甚至直接忽略掉SEO的布局设计等等,这些都需要磨合,除此之外你也要灵活多变,平时也多与设计人员social,这样在一定程度上也有助于项目顺利进行。

后面就是评审环节,这个部分没有什么好说的。(倒是有一些吐槽,还是忍住不说了。)

1.4 开发-交付-测试-上线环节

到了这一环节,自然而然是SEOer们核心关注的部分,因为在前期策划中引入了SEO的优化思维,所以格外需要叮嘱开发者们务必按照SEO方案进行建站,交付及测试环节可以直接查看网站的代码进行检验,比如:伪静态或纯静态链接设置、301重定向、404自定义错误页面设置、sitemap/robots协议、链接层级、面包屑导航、nofollow/noindex标签运用、页面H1-H6设置、文章标题采用H1与否、logo title标签添加关键词、文章图片ALT标签、网站有无JS/iframe、图片有无压缩(gzip的配置)、网站的响应速度等等系列,都需要仔细测试,通过源代码和其他的站长工具进行审计,不符合规范的就写一个走查报告给到开发处理。关于上述这些具体细节我们在下个章节进行逐一讲解。以上环节确定无误即可安排上线(当然上线前的文案与设计审计工作是达标的前提下进行的。)

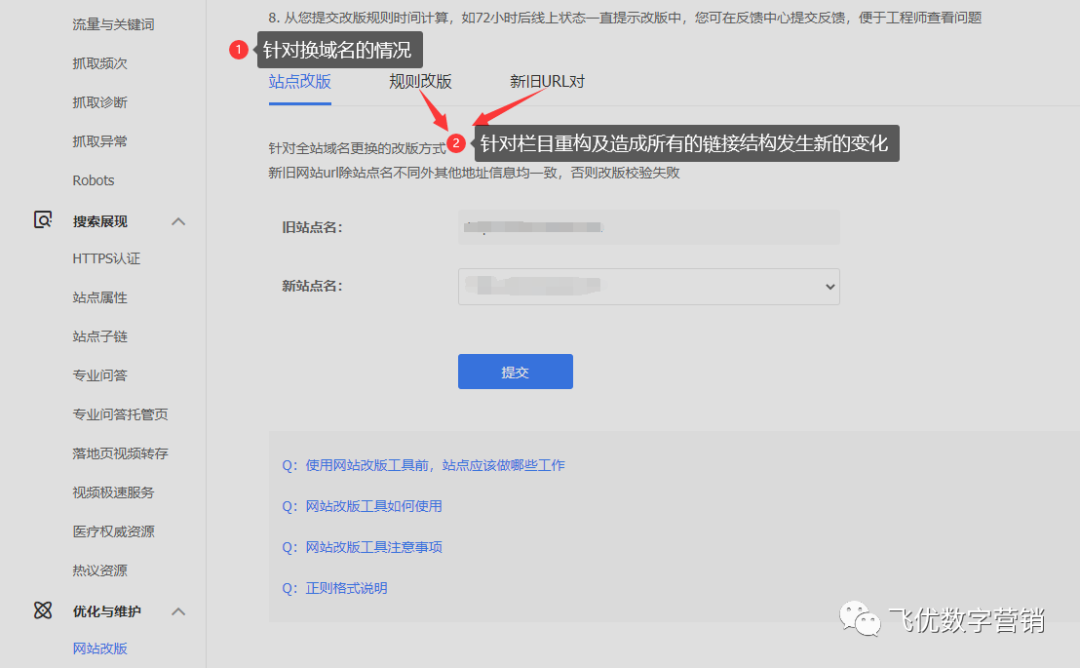

另外还一个特别重要的一点,若是改版将原有的目录结构全部替换了,那就需要在百度后台提交改版规则,这个目的就是为了减少前端已收录页面出现死链,提交改版规则能有效解决并继承原有的排名。不懂的不要随便操作,请将它留给开发人员。

确保网站可被爬虫抓取

说到网页抓取先需要了解下定义,什么是网络爬虫?何谓网站抓取?先引用下维基百科的解释:

网页抓取俗称“ Web Scraping ”,网页抓取和网页索引极其相似,其中网页索引指的是大多数搜索引擎采用使用的机器人或网络爬虫等技术。与此相反,网页抓取更侧重于转换网络上非结构化数据(常见的是HTML格式)成为能在一个中央数据库和电子表格中储存和分析的结构化数据。网页抓取也涉及到网络自动化,它利用计算机软件模拟了人的浏览。

——引用自wikipedia

这个不好理解,说人话就是利用网页爬虫或者机器人(不同搜索引擎对爬虫的称呼,百度叫Baiduspider,谷歌叫Googlebot,它们都属于搜索引擎里的一个模块)从网站中提取内容和数据的过程。从搜索引擎工作原理上看,具体强调网络爬虫的工作流。

要说爬虫是1,那抓取及收录就是后面的0。大家也应该常常听到圈内人说蜘蛛池,其实就是这个意思(先抓后收)。所以网页抓取是开展SEO优化工作的良好开端,没有抓取就没有收录,更不可能有搜索引擎排名了,对于SEOer而言,做好网页抓取是开展SEO工作的第一步!

自然有人会思考“那要是网页抓取异常该怎么办?”

百度搜索引擎针对网页抓取异常做过明确说明,“Baiduspider无法正常抓取网站内容,会默认判定你的网站是缺乏用户体验的,不会给予网站流量。"

读到这里,大家势必对网页爬虫的工作原理产生好奇,那我们再来说说搜索引擎爬虫的工作流问题,如下图所示:

网络爬虫的工作原理图

1.首先选取一部分经分析后的种子URL;2.将这些URL放入待抓取URL队列;3.从待抓取URL队列中取出待抓取在URL,解析DNS,并且得到主机的ip,并将URL对应的网页下载下来,存储进已下载网页库中。此外,将这些URL放进已抓取URL队列。4.分析已抓取URL队列中的URL,分析其中的其他URL,并且将URL放入待抓取URL队列,从而进入下一个循环。

上述内容理解起来可能有点困难,我们换个角度来理解,有基础的SEOer一定知道两个常见的搜索引擎抓取算法策略:广度优先抓取策略和深度优先抓取策略。当然,还有一个大站优先抓取策略(权重高的站点,一般都是一些资讯门户类)。上图的工作原理可以通过这两大策略进行阐释。

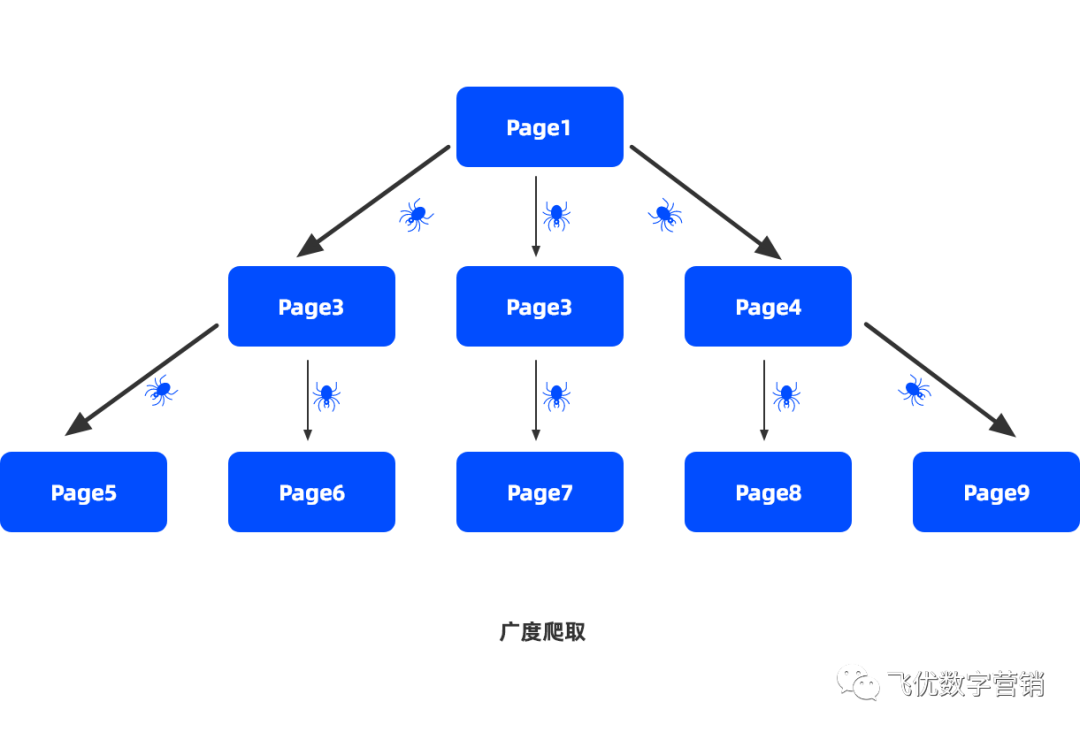

广度优先抓取策略

广度优先抓取策略是通过待抓取URL列表为基准进行抓取,发现的新链接,且判断为未抓取过的基本就直接存放到待抓取URL列表的末尾,等待抓取。我们用这一张图来说明,如下:

什么意思呢?举个通俗的例子:

假设爬虫的待抓取URL列表中,只有Page1这个原始网页,爬虫从Page1开始抓取,从Page1中提取了Page2、Page3、Page4,于是将Page2、Page3、Page4放入到抓取队列,再依次获得Page5、Page6、Page7、Page8、Page9网页并插入到待抓取的URL列表中,以此类推,周而复始。简单理解就是由一生二,二生三的结果。

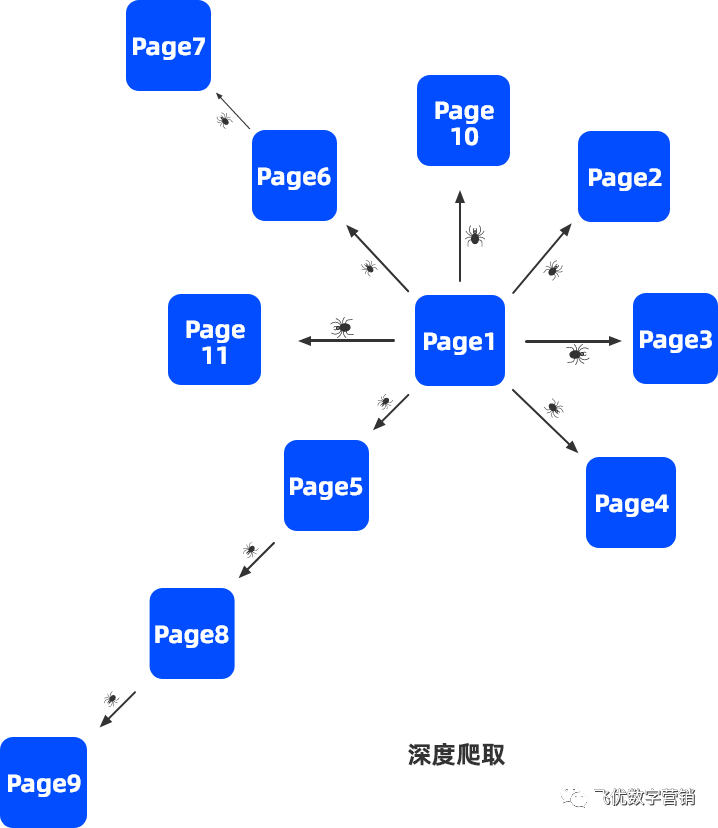

深度优先抓取策略

深度优先抓取的策略是爬虫会从待抓取列表中抓取第一个URL,然后沿着这个URL持续抓取这个页面的其他URL,直到处理完这个线路后,再从待抓取的列表中,抓取第二个,以此类推。同样用一张图来示意说明,如下:

Page1作为第一个从待抓取列表的URL,爬虫开始抓取,然后抓取到Page2、Page3、Page4、Page5、Page6,Page10、Page11,但Page2、Page3、Page4中都没有后续的链接了(忽略已经抓取过的页面),从Page5中发现了Page8,顺着Page8,发现了Page9,然后就没有更多了。在Page6中发现了Page7,然后针对这个链接的抓取就结束了。从待抓取列表中,拿到下一个链接循环继续上述操作。

因此再结合百度给出的解释,爬虫能正常抓取网页内容且满足用户体验的条件后网页才会有排名,有了排名才有流量。当然这里省略了网页排名的算法,属于另外第一个知识点,这里不多讲了。

大站优先抓取策略

其实这个策略算是前面两个的结合体,广度与深度都做得好的站势必也会是大站点,常见的如新浪、搜狐等,所以结合日常Seoer外链及站内工作内容,也说一下这个扩展知识点——爬虫优先抓取大战策略。

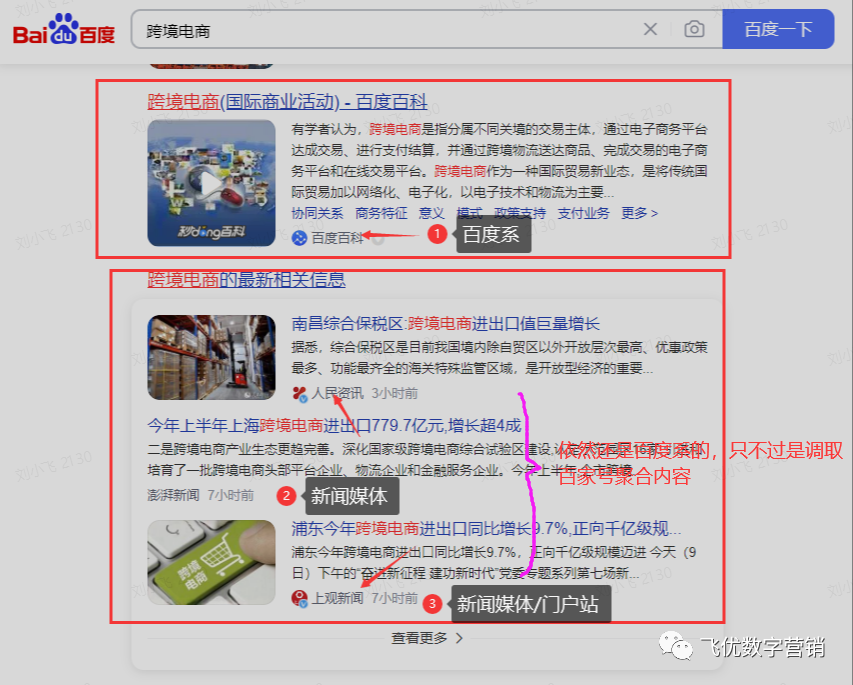

优先抓取意思1:优先抓取权重较高的站点;

比如:搜索 "跨境电商",SERP结果页面基本上是百度自家产品和第三方新闻媒体和深度媒体站点,你要是再去点进进去查看基本上是百家号的信息聚合,说白了还是自家产品,仔细看下它们的权重基本上是权10以上,你想一个刚出来的企业站能拼得过吗?

SERP结果呈现

优先抓取意思2:爬虫将待抓取列表里的URL按照域名进行归类,然后计算数量。其所属域名在待抓取列表里数量最多的优先抓取。什么意思呢,看下图示例:

我在前面讲过,待抓取的种子URL地址一般性均是Hub页面/权威性页面为主,这也就是说为什么鼓励大家去找高权重站点发优质外链的原因,以上图为例,假定待抓取的页面是一个权威性的页面,网站中除了头部及底部导航是固定不变之外,其他的从A-J区域都可以你的URL地址,那么,爬虫会根据待抓取的URL(A-J)中识别不同类型的域名进行分类,然后自动加权计算所有链接中的数量,数量越多就越有优先抓取的机会。这里大家可能会产生疑问,为什么会进行域名分类?因为权威性的页面不止单服务你一个用户,是公共的,大家都可以去做(前提是你能发掘到这样的宝藏)。

所以,总的说来,优先抓取的两个解释一个是针对网站权重高的,一个是针对每天文章发布数量高且发布很集中的。不过我们试想一下,发布集中且数量篇幅多的站点,一般也应该是大站了吧?

所以给我们的启发就是提权并且更新文章需要集中固定到具体时间,不要三天打鱼两天晒网,最好能养成输出文章的固定习惯,这样有助于培养蜘蛛对你站点访问的习性,有助于收录。

以上是通过网页抓取引申出的知识点,但是回到正题"确保网页能正常抓取"则需要通过站长工具进行测试,可以登录百度后台进行查看,如下图:

除此之外,还有一种可能就是当用第三方CMS程序(wordpress)建站时,大部分的站长会在后台开启禁止搜索引擎抓取或通过Robots.txt进行屏蔽搜索引擎对网站根目录的抓取,因此你需要进行后台关闭或修改robots协议。

当然也还有一种特殊情况,直接在服务器中进行屏蔽后的解锁,这个就不在这里展开了。

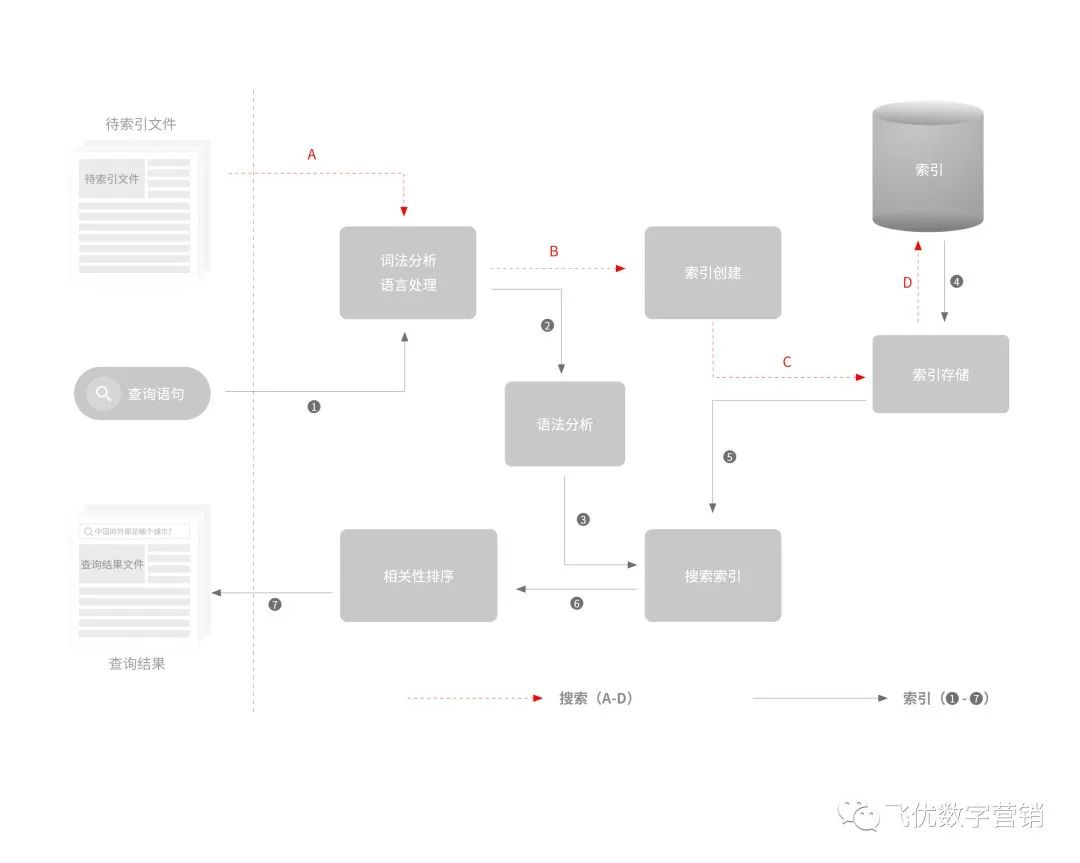

确保内容可被索引

关于内容被索引的问题,我觉得大家先放一放,我们先了解这几个SEO易混淆的名词:抓取、收录、索引。搞懂之后你才能更好地玩转收录,甚至达到秒收的结果。

抓取这部分已经在第二小结里讲过了,不再重复。说说收录和索引。

先看下百度官方文档介绍是如何说收录与索引的定义

收录和索引分别指什么?

收录:页面被Baiduspider发现、分析过的;言外之意,也就是蜘蛛先爬行后抓取再实现收录的过程。

索引:Baiduspider经初步分析后认为有意义,做建库处理。言外之意就是可能参与未来有排名的页面,这里代表有质量的网页,也称之为上层索引。

按我的理解

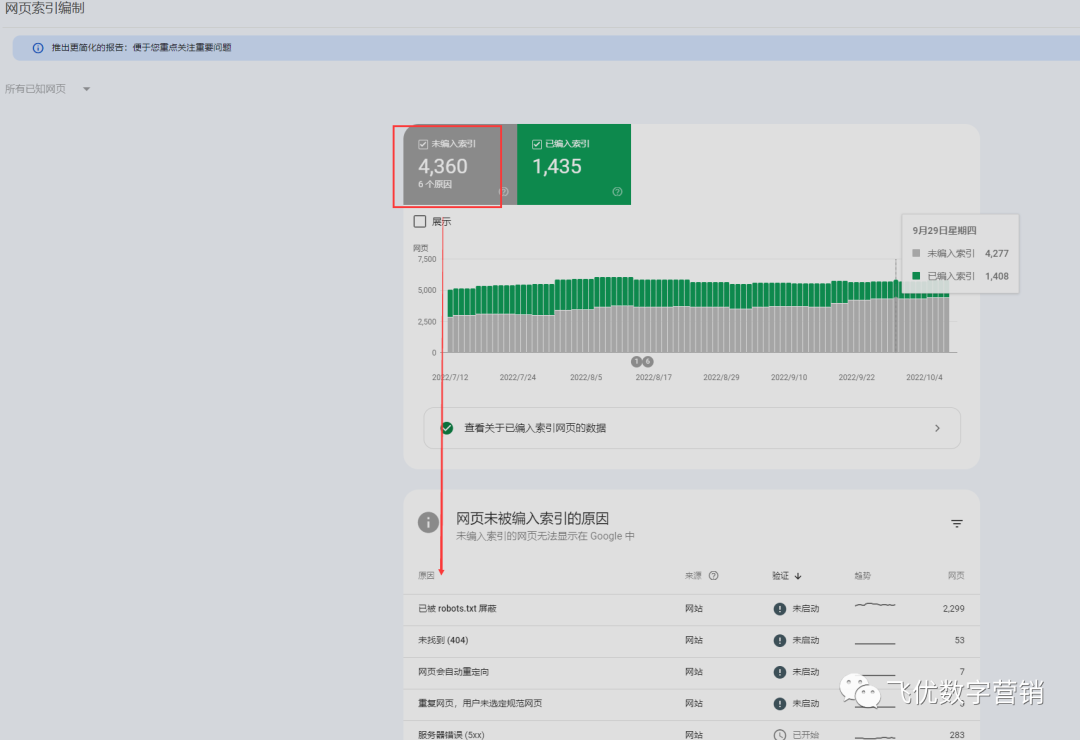

索引和收录是两个不同的东西。仅仅因为搜索引擎可以抓取页面并不意味着他们可以将其编入索引。如果页面上有 “noindex” robots标记或x‑robots-tag,则无法编制索引。Google会在覆盖率报告中告诉你未编入索引的URL及原因。以下未编索引是因为当初改了一个目录结构导致,没想到被秒收,系统被抓取,后来又重新改回默认目录,目前等Google数据库恢复。

Tips:如果你有应编入索引的页面被标记了 “noindexed”,请删除 “noindex” 标签。

收录和索引的关系?

二者是包含关系,先收录才可以建索引,收录量大于索引量。百度搜索资源平台普通收录工具是通往收录的大门。

由此可见,可以大致理解爬虫爬行>抓取>收录>索引。而大部分理解的收录就等同于索引了,举个之前优化的case:site指令下的收录量1000+,但是百度站长后台的索引量数据是7000+,造成数据为什么不一致?

按照官方解释,site语法下的数据只是预估数据,不太准确。因此参考意义不大。那具体什么原因导致?

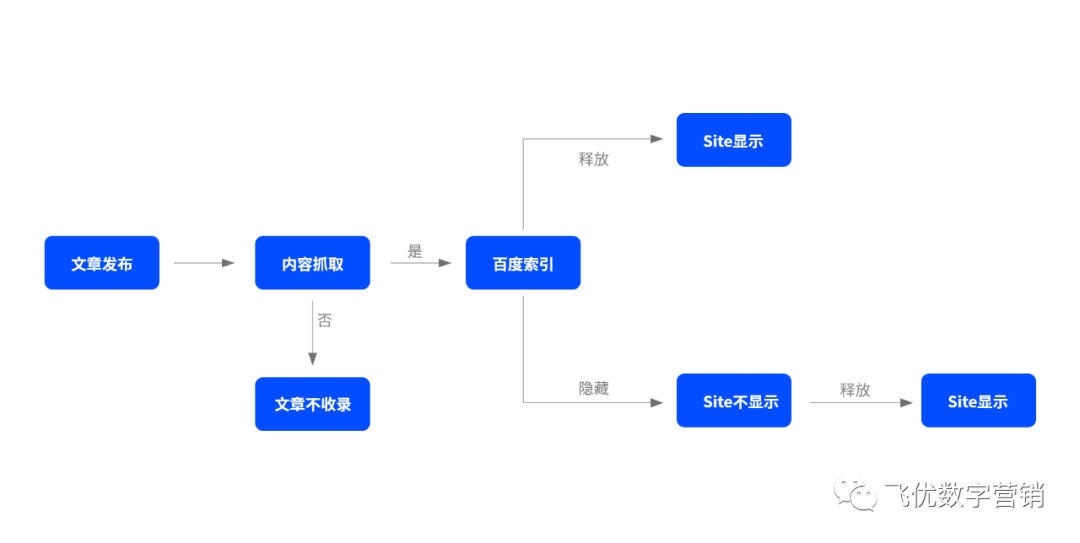

我们后来经测试发现,原来site出来的是缓存数据,并不是所有的收录页面数。换句话说site出来的结果就是用户经常搜索看到的结果,而索引库的数据是你全部的数据。索引里还包含上层索引和下层索引,具体可以理解为上层索引是较为优质的,下层索引一般甚至低质的。以一篇文章的收录过程作说明:

不信你看看下面的测试:

你会发现,site出来的收录基本上是与用户经常相关的,其他的基本上被百度默认给屏蔽了。那我们再还原下搜索引擎的基本原理,用2张图解释索引在搜索中扮演的角色。

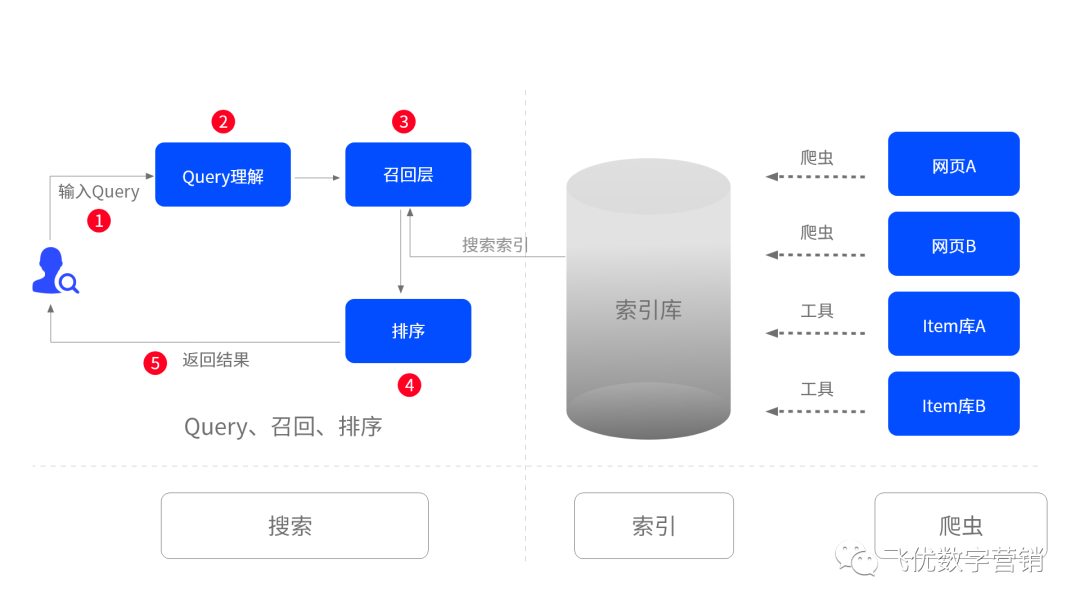

搜索引擎五大模块协同过程

以搜索需求为例:

从显性角度看:人-搜索引擎-返回结果,完成整个搜索需求的过程;

但是,从隐性的角度(搜索引擎)看:完成搜索指令需要将爬虫、索引、Query、召回、排序等5个过程协同,当用户在屏幕前开始搜索动作时,系统已经开始飞速运转,爬虫先完成从A-D的抓取-收录-索引的过程,提前为Query模块做准备,以查询语句为开端经过流程1-7的运作,最后找出相关性较高的页面展现在用户面前。展现在用户面前的也就是我们目前的上层索引,能满足用户的需求的页面。

爬虫-索引-query理解-召回-排序的工作原理

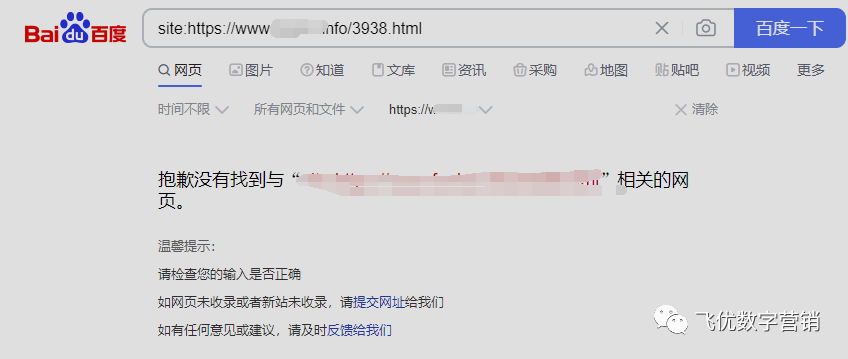

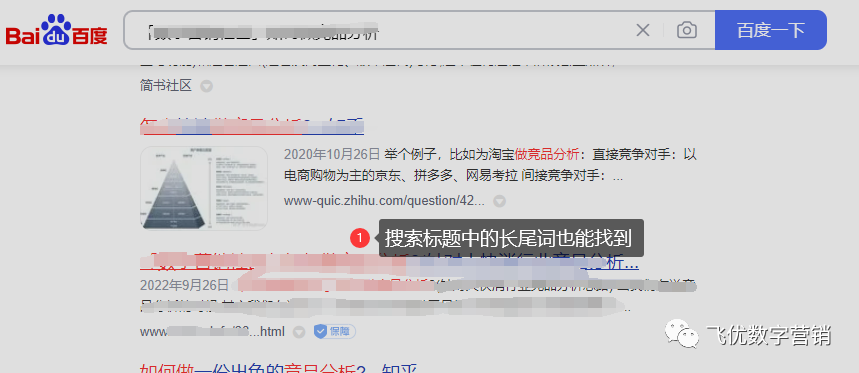

这里又涉及到一个知识点,怎么区分上层索引及下层索引?其实很简单,如果你的网页被收录了,但是搜索全标题,却没有或者排名不在首页,大概率可以评为下层索引,如果你搜索标题中的长尾词,然而排名在首页。那大概率可以评为上层索引。

你只需要将目标的网页进行输入搜索:目标URL地址,看到这样的返回结果,找不到应有的链接就说明是下层索引,如:

下层索引示例

上层索引例子:直接搜链接查有无收录,有则再次输入链接中带有关键词的长尾词查询,看有没有排名。

链接搜索查询

通过长尾词搜索后的排名

收录和索引的意义?

收录意义1:收录是索引的前提,站点需要保持服务器稳定(参考抓取诊断工具、抓取异常工具)、robots正确(《robots写法和需求用法对应表》),为Baiduspider抓取铺平道路;

收录意义2:Baiduspider只能处理已分析过的页面,面对新旧页301和移动适配,可为已收录页面完成权值评分以及流量切换;

索引意义1:只有被建入索引库的网页才有获得流量的机会(网页虽然被建入索引库,但获得流量的机会并不同,无效索引很难获得流量);

索引意义2:新闻源站点(新闻源目录)内的链接,必须先被网页库建索引,才有机会出现在新闻检索中。

以上就是关于围绕“索引”展开的知识点介绍,正所谓“知其然亦知其所以然”这样才能更好地完成优化工作。

确保网站使用HTTPS

Https是目前非常流行的一种网络传输协议,与安全有关,大家可以不用了解那么具体,我们只需弄清楚他怎么应用就好。我们先看看它长什么样:

就是在你的浏览器输入框URL地址前有一个小绿锁的标志“”,在你浏览其他的网页时可能会遇到这种页面,如下:

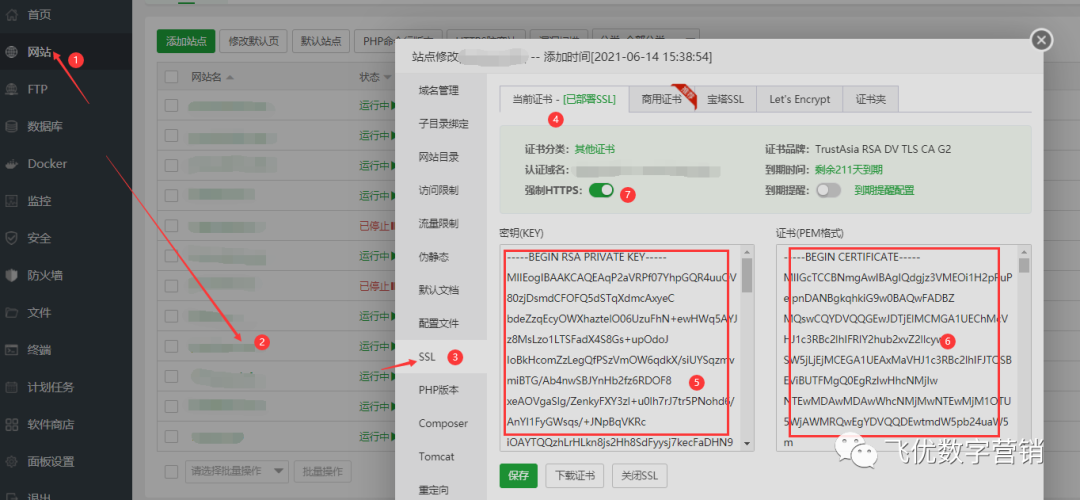

这就是没有配置HTTPS的站点,那我们具体怎么来实现从Http-Https配置,具体做法(以linux主机>宝塔面板为例),登录宝塔后台,按照1-7的顺序配置即可。

关于步骤5和步骤6的Key与PEM,你可以登陆到你的云服务商(阿里或者腾讯云),找到SSL证书栏目,然后会有免费申请,点击申请就好,一般会在15分钟审核通过,审核前需要做好目标域名绑定,再选择你的服务器主机类型,是Linux就选择Linux,是Win机的就选择Win机,对应的主机类型下选择下载证书,这个部分略,不清楚的直接搜度娘。

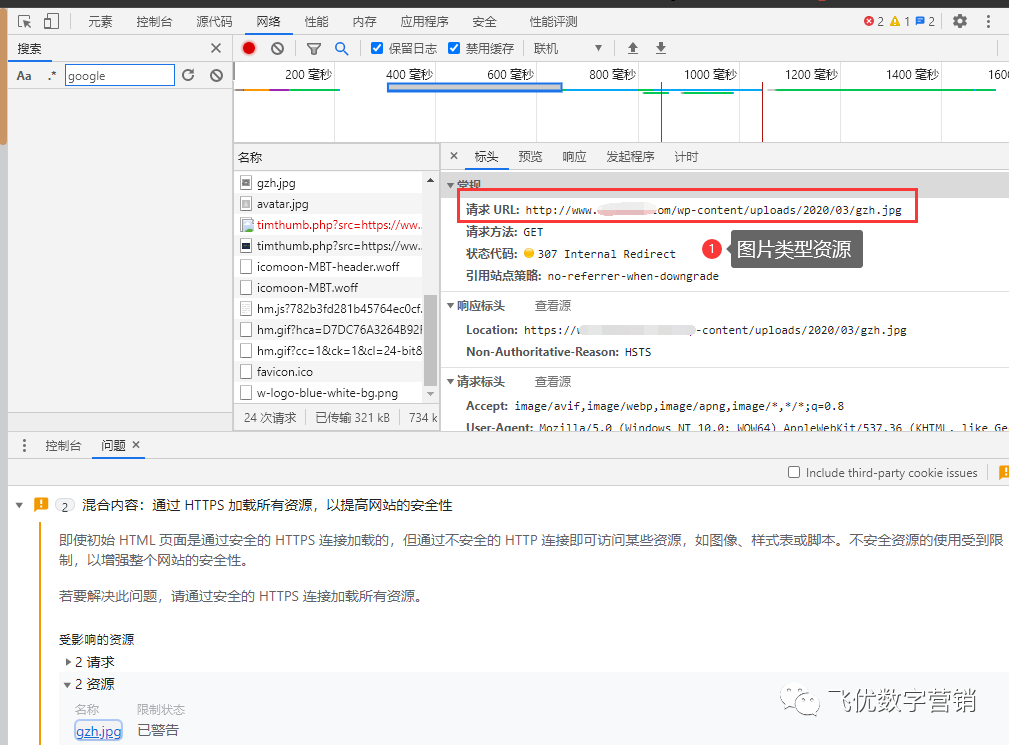

当然,所有配置好后你可能会遇到这种带黄色警示锁的标记,如:

这表示你的Https没有配置成功,你可以F12定位下看报错类型,一般来说,是由于没有将原Http资源转化成Https资源,具体看是什么类型的,是图片还是视频等,若是,直接修改下上传的目录改成正确的URL地址。

确保网站唯一域访问

简单来说就是不要分散权重,确保打开链接域名是具有唯一性的,怎么理解?举个例子:

http://abc.com ...①

http://www.abc.com ...②

https://abc.com ...③

https://www.abc.com ...④

以上四个站点的首页都是一样,但是在搜索引擎的世界可能是4个不同类型的站,因此很容易造成权重分散,遵循百度搜索引擎规则,我们可以将①②③种域名301重定向到④,其实也不用这么麻烦,Https配置成功,你打开①和②会自动变成③和④,所以你只需要做好将③的域名301重定向到④就好。

同理,按Google的原理,更侧重使用③域名,那就直接将其他三类的域名301到类型③就好。至于怎么做301重新定向,不清楚的就直接给到网站开发人员或者运维同学完成就好。

确保网站加载速度快

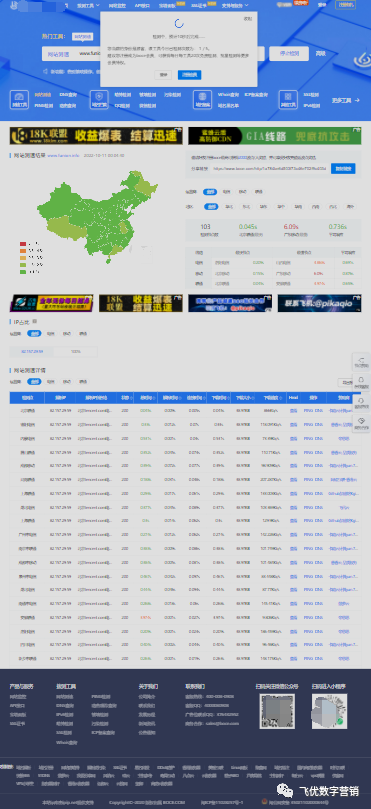

网站的体验好不好,一半也取决于你的服务器配置,其中网站的加载速度是一个很重要的方面,网站加载速度有一个标准,要在3s之内响应,否则容易流失用户。不知道如何查询自家网站访问速度的可以使用以下工具:拨测

假如出现一片红,那就是服务器的配置较低,尤其是带宽,这样你可以跟运维沟通,让其验明情况,确定是配置导致的那就升级。

确保网站移动端友好

移动端友好这是一个老生常谈的问题,以目前移动互联网的发展趋势来看,大部分的企业都已经保持了“PC+移动”的标配,但是做到友好的标准需满足适配这一基本条件,除此之外就是移动端页面体验度。

移动端适配

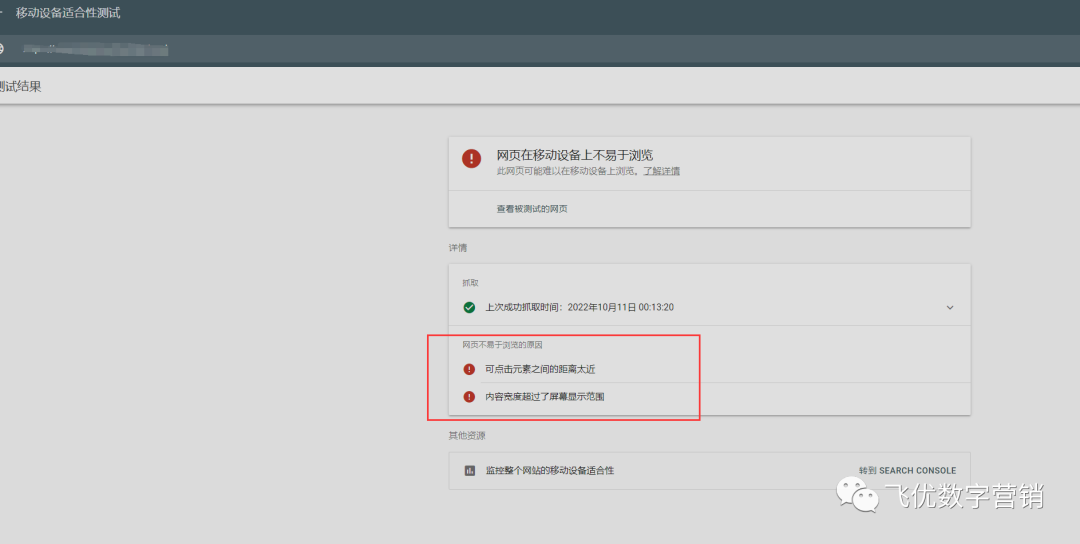

你可以是自适应,也可以是独立的移动站,但是一定要做好适配,切莫出现这种情况:

页面体验度测试

利用Google 移动页面测试,找出问题,然后排查。

查询地址:https://search.google.com/test/mobile-friendly

处理图片压缩问题

一般而言,在网站开发环节中会针对图片过大的问题采用以下解决方案,通过tinyPNG在线工具压缩所有图片进行上传,图片输出控制在10Kb以内,有助于网页加载。

第二种就是针对第三方博客安装插件解决,如WP的ShortPixel。

第三种进行OSS上传,将所有图片及视频等文件搬到云存储盘,同样也需要保持图片的输出大小,然后挂上全站CDN,这样便于快速访问。

清除和优化无效链接

无效的链接包括404页面打不开及死链等情况,包括站内与站外。这些统称为无效链接,会对用户体验产生负面影响,网站权重上升的绊脚石。针对这两种情形怎么处理?

站内:可以通过site指令输出所有的收录链接,手动一条条测试,找到那些死链和无效链接,并记录URL地址,这种做法只适合收录比较少的网站,一旦是收录超1000的这个可能就有点崩溃了,那针对这一情形,我推荐你用360浏览器扩展404 link检测,安装后,输入地址点击按钮即可自动查找,有问题的链接会用“X”表示,非常省事。

站外:主要是针对外链平台发布内容后直接删掉资源及自身站点的原因导致链接失效,那因此你需要重新补充恢复,用正确的链接替换。按照现在的做法,这种已经不流行了,因为大部分的平台都不允许私带链接。

当然,若你觉得这种做法也是很心累,那你可以利用Ahrefs工具查找是无效链接。

去掉重复内容

重复内容是SEOer常爱干的事儿,对于蜘蛛来说是灾难,因为蜘蛛喜欢新的东西,旧的及在库里有的它不会再爬,因此很容易被判定为低质垃圾内容,所以在编辑文章过程中尽量做原创,没那个能力可以考虑下伪原创,就是不能直接copy,有人会说,我copy你能察觉得到吗?那我教你一个小妙招检测网站的重复内容,如下:

1.查看单篇文章是否重复,可用{title+文章标题}进行查询;

2.查询某篇文章是不是被copy,可从文章首段复制一段文字,在百度搜索框进行搜索,前提是该文章被收录了。如果发现大量飘红文字,则说明这篇文章重复性过高;

3.可通过站内搜索文章标题,可查询出重复的内容(前提是有站内检索功能);

4.利用SEO站长工具页面相似度检测工具,判断一些相邻页面的相似度,80%以上相似度就需要对一些固定栏目进行调整。

写在最后

以上内容就是整理后的2022年B2B官网优化指南(上部)的内容,希望分享的内容能给大家带来些许思考。码字不易,希望您给个关注或转发,若是想进一步了解关于SEO优化,可以订阅飞优数字营销。

免责声明:市场有风险,选择需谨慎!此文仅供参考,不作买卖依据。

关键词:

营业执照公示信息

营业执照公示信息